À l'ère numérique, les données sont souvent considérées comme le nouvel or. Les entreprises, les chercheurs et les particuliers s'appuient tous sur les données pour prendre des décisions éclairées, acquérir des connaissances et rester compétitifs. Le "web scraping", qui consiste à extraire des données de sites web, est devenu un outil indispensable dans ce processus de recherche d'informations. Cependant, la recherche sur le web n'est pas sans poser de problèmes, le plus important étant la nécessité d'avoir recours à un agent. Dans ce guide complet, nous allons explorer comment vous pouvez tirer parti des proxys de scraping pour améliorer vos efforts de scraping de données et vous donner un avantage concurrentiel.

En savoir plus sur le Proxy Scraping

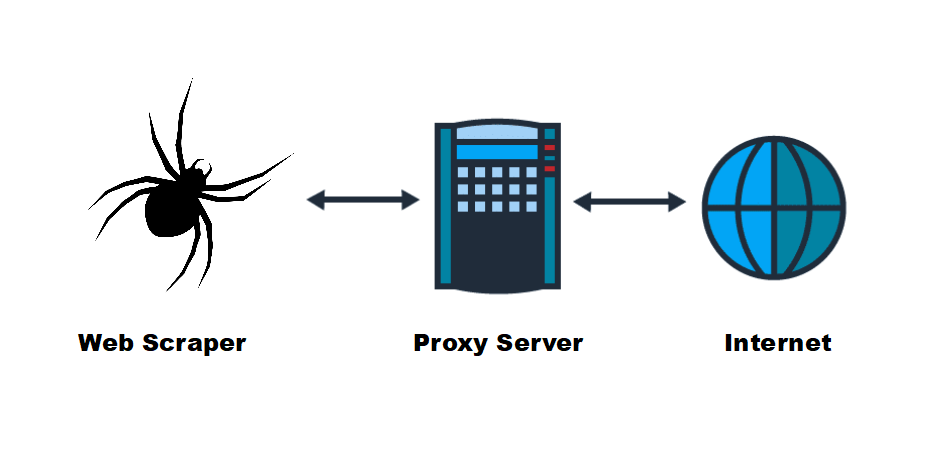

Avant de nous plonger dans l'utilisation des proxys pour le web scraping, clarifions d'abord ce qu'est un proxy et ce qu'il fait. Un proxy agit comme un intermédiaire entre votre ordinateur et le serveur web auquel vous essayez d'accéder. Lorsque vous utilisez un proxy pour demander des données à un site web, le serveur proxy effectue la demande en votre nom, en masquant votre adresse IP. Cette fonction est cruciale pour les recherches sur le web, car elle vous permet de rester anonyme et d'éviter d'être détecté.

Pourquoi utiliser un proxy pour le web scraping

A. Surmonter les blocages et les restrictions IP

De nombreux sites web utilisent des mesures anti-scraping pour empêcher la collecte automatisée de données. Ils peuvent bloquer les adresses IP qui effectuent un trop grand nombre de requêtes dans un court laps de temps, ou restreindre l'accès aux utilisateurs de régions spécifiques. En utilisant un serveur proxy, vous passez par un ensemble d'adresses IP, ce qui rend difficile la détection et le blocage de votre activité de recherche par les sites web.

B. Garantir l'anonymat et le respect de la vie privée

L'exploration de plusieurs pages web ou sites web sans proxy peut entraîner l'interdiction de votre adresse IP. Non seulement cela perturbe votre collecte de données, mais cela compromet également votre vie privée. Les proxys offrent un anonymat supplémentaire, garantissant que votre véritable adresse IP reste cachée lorsque vous récupérez des données sur le web.

Type de proxies pour le scraping

Il existe plusieurs types de serveurs proxy, chacun ayant ses propres avantages et utilisations :

A. Mandataire résidentiel

Un proxy résidentiel est une adresse IP attribuée à une zone résidentielle réelle. Comme ils ressemblent à des connexions d'utilisateurs légitimes, les sites web leur accordent une grande confiance. Les proxys résidentiels sont idéaux lorsque vous devez accéder à des données provenant d'un site web dont les mesures de sécurité sont strictes.

B. Proxy de centre de données

Un proxy de centre de données est une adresse IP hébergée dans un centre de données. Les proxys de centre de données sont plus rapides et plus rentables que les proxys résidentiels, mais les sites web ne leur font pas forcément confiance. L'agent pour centre de données convient aux tâches qui requièrent rapidité et efficacité.

C. Serveur proxy SOCKS

Les serveurs mandataires SOCKS sont polyvalents et peuvent gérer tous les types de trafic internet, ce qui en fait un choix populaire pour les recherches sur le web. Ils allient sécurité et performances, ce qui en fait un choix complet pour la collecte de données.

D. Procuration tournante

Les proxys rotatifs changent constamment d'adresse IP, ce qui rend difficile l'identification et le blocage des activités de recherche par les sites web. Ils constituent un choix populaire pour les opérations de recherche à grande échelle.

Choisir le bon fournisseur de proxies pour le scraping

Le choix du bon fournisseur de proxy est essentiel au succès de vos efforts de recherche sur le web. Tenez compte de facteurs tels que la fiabilité, la vitesse, la couverture géographique et le prix lorsque vous choisissez un fournisseur. Luminati, Oxylabs et Smartproxy sont des fournisseurs de proxy couramment utilisés.

Mise en place et configuration d'un proxy de scraping

Configuring a proxy for web scraping requires adjusting the scraping tool’s settings so that requests are routed through the proxy server. Additionally, you may need to handle authentication and implement a proxy rotation strategy to avoid detection.

Meilleures pratiques pour l'utilisation du proxy de scraping

Le Web Scraping n'est pas une panacée, et l'utilisation efficace d'un serveur proxy nécessite le respect de bonnes pratiques. Envisagez d'utiliser la limitation de débit et l'étranglement, la surveillance et la journalisation, ainsi qu'un traitement robuste des erreurs pour garantir des opérations de recherche fluides.

Dépanner les problèmes de proxy les plus courants

Malgré tous vos efforts, vous pouvez rencontrer des problèmes tels que le blocage d'IP et les CAPTCHA lors de la collecte de données sur le web. Il est essentiel d'apprendre à résoudre ces problèmes courants liés aux agents pour maintenir un processus de collecte de données transparent.

Étude de cas

Des exemples concrets de web scraping réussi à l'aide de proxys peuvent vous donner des indications précieuses sur la manière d'appliquer les proxys à diverses situations. Ces études de cas illustrent les avantages pratiques de l'intégration d'agents dans votre flux de collecte de données.

Conclusion

En résumé, la recherche sur le web est un outil puissant de collecte de données, et les mandataires sont la clé qui permet d'en exploiter tout le potentiel. En utilisant un proxy, vous pouvez surmonter le blocage IP, garantir l'anonymat et collecter des données plus efficacement. Avec le bon fournisseur d'agence et les meilleures pratiques en place, vous pouvez améliorer vos efforts de collecte de données et obtenir un avantage concurrentiel dans le monde actuel axé sur les données.