Scraping erfordert oft robuste Proxy-Sites, um IP-Sperren zu umgehen, große Datenanforderungen zu verarbeiten und die Anonymität zu wahren. Die Auswahl hochwertiger Proxy-Anbieter gewährleistet Stabilität, Geschwindigkeit und Erfolg bei Web-Scraping-Projekten. Im Folgenden finden Sie einen detaillierten Leitfaden zur Auswahl guter Proxy-Sites und zur Beantwortung häufiger Fragen.

Warum sind Proxies für Web Scraping unerlässlich?

Proxys fungieren als Vermittler zwischen dem Scraper eines Nutzers und den Ziel-Websites und verschleiern die echte IP-Adresse des Scrapers. Indem sie durch mehrere Proxy-IPs rotieren, können Nutzer eine Entdeckung vermeiden und verhindern, dass ihre Scraper blockiert werden.

Hauptmerkmale einer guten Proxy-Site zum Scrapen

- Großer Proxy-Pool: Minimales Risiko von IP-Sperren durch rotierende Proxys.

- Anonymität: Schützt die Identität des Benutzers, indem die echte IP-Adresse verborgen wird.

- Schnelle Reaktionszeit: Entscheidend für die Aufrechterhaltung der Schabeeffizienz.

- Geo-Targeting-Fähigkeiten: Ermöglicht den Zugang zu lokalisierten Inhalten, indem IPs aus bestimmten Regionen angeboten werden.

- Unterstützung von Protokollen: Kompatibel mit HTTP-, HTTPS- und SOCKS5-Protokollen.

Bezahlte/freie Proxy-Seiten für Scraping

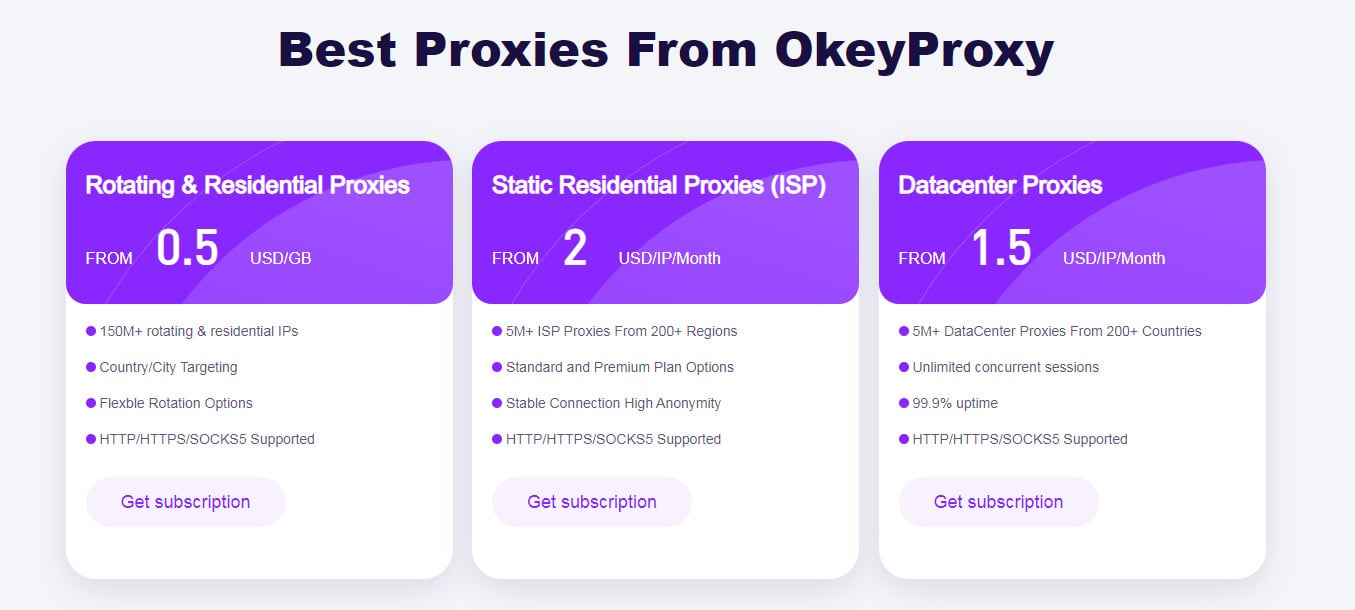

Führender Proxy-Anbieter - OkeyProxy

OkeyProxy ist ein professioneller Proxy-Dienstleister, der für die Bereitstellung hochwertiger, zuverlässiger Lösungen bekannt ist, die auf die unterschiedlichen Bedürfnisse der Nutzer zugeschnitten sind. Er bietet statische und rotierende Proxys mit SOCKS5- und HTTP(S)-Unterstützung, die sichere, schnelle und anonyme Internetverbindungen gewährleisten. OkeyProxy wurde für Anwendungen wie Web-Scraping, SEO-Monitoring und die Umgehung von Geobeschränkungen entwickelt und ist ideal für Unternehmen und Entwickler, die einen effizienten Online-Betrieb wünschen. Mit einer benutzerfreundlichen Oberfläche und skalierbaren Optionen sorgt es für eine nahtlose Integration in Arbeitsabläufe bei gleichzeitiger Einhaltung robuster Datenschutzstandards.

-

Merkmale:

Premium-Proxys für Privatanwender und Rechenzentren mit automatischer Rotation.

-

Anwendungsfälle:

Perfekt für das Scraping sensibler oder hochsicherer Websites, die einheitliche IPs erfordern.

-

Vorteile:

Großer IP-Pool, hervorragende Kundenbetreuung, erschwingliche, stabile Verbindungen, SOCKS5-Kompatibilität und Code-Integration.

-

Nachteile:

Premiumpreise sind für kleinere Budgets möglicherweise nicht geeignet.

Scraping-Proxy im kleinen Maßstab - HideMyAss

HideMyAss (HMA) Kostenloser Proxy ist ein webbasiertes Tool, das schnelles und zugängliches anonymes Surfen ermöglicht. Es ermöglicht Nutzern, regionale Beschränkungen zu umgehen und ihre IP-Adresse beim Zugriff auf Websites zu verbergen. Im Gegensatz zu Premium-VPN-Diensten ist der kostenlose Proxy in seinen Funktionen eingeschränkt, bietet aber dennoch grundlegende Funktionen wie die Maskierung von IPs und die Verschlüsselung von Verbindungen. Er eignet sich besonders für gelegentliche Aufgaben wie den Zugriff auf geoblockierte Inhalte oder die Wahrung eines minimalen Datenschutzes im Internet.

- Merkmale: Webbasierter Proxy für schnelles Surfen; freie IPs für manuelle Konfiguration.

- Vorteile: Einsteigerfreundlich und ohne Anmeldung

- Nachteile: Langsamere Geschwindigkeiten; ungeeignet für großflächiges Schaben.

Proxy-Listen für HTTP-, HTTPS- und SOCKS5-Protokolle

ProxyScrape ist eine beliebte Online-Plattform, die kostenlose und hochwertige Proxy-Listen für Aufgaben wie Web-Scraping, Browsing und Anonymität bereitstellt. Sie bietet HTTP-, HTTPS- und SOCKS-Proxys, die aus einer umfangreichen Datenbank stammen und regelmäßig aktualisiert werden, um Aktualität und Funktionalität zu gewährleisten. Der Dienst enthält Funktionen wie das Filtern von Proxys nach Anonymitätsstufen, Geolocation und Geschwindigkeit und ist damit für eine Reihe von Online-Aktivitäten geeignet. ProxyScrape bietet außerdem APIs für die nahtlose Integration mit Automatisierungstools und unterstützt Anwendungsfälle wie SEO-Überwachung, Umgehung von Geobeschränkungen und Anzeigenüberprüfung.

- Merkmale: Kostenlose Proxy-Listen mit Statistiken zur Betriebszeit.

- Vorteile: Einfache Filterung nach Anonymitätsstufe und Region.

- Nachteile: Proxies können aufgrund ihrer öffentlichen Verfügbarkeit schnell überstrapaziert werden.

Wie man die beste Proxy-Site für Scraping auswählt

Die Auswahl der besten Proxy-Site für Web-Scraping ist entscheidend für die Gewährleistung von Effizienz, Anonymität und Datengenauigkeit. Hier sind die wichtigsten Schritte:

-

Verstehen Sie die Ziel-Website

Analysieren Sie Anti-Scraping-Maßnahmen wie IP-Sperren oder CAPTCHA-Anforderungen. Wählen Sie außerdem Proxys aus, die der Komplexität der Zielsite gerecht werden.

-

Entscheiden Sie sich für den Proxy-Typ

Wählen Sie je nach Bedarf zwischen Residential-, Data Center-, statischen oder rotierenden Proxys.

- Vollmachten für Wohnzwecke: Am besten geeignet, um eine Entdeckung zu vermeiden, da sie echte IP-Adressen von ISPs verwenden.

- Rechenzentrum-Proxys: Kostengünstig für große Mengen an Schürfwunden, aber anfälliger für Verstopfungen.

- Statische vs. rotierende Proxys: Statische Proxys sind ideal für konstante Sitzungen, während rotierende Proxys helfen, Ratenbeschränkungen zu umgehen.

-

Größe und Standort des Proxy-Pools evaluieren

Entscheiden Sie sich für größere Pools mit geografisch ausgerichteten IPs, um bessere Ergebnisse zu erzielen. Ein größerer Proxy-Pool verringert das Risiko wiederholter IP-Sperren, und geografisch ausgerichtete Proxys sind für das Scraping regionsspezifischer Inhalte unerlässlich.

-

Berücksichtigen Sie Budget und Skalierbarkeit

Passen Sie den Dienst an den Umfang des Projekts und das Wachstumspotenzial an.

Tipps für den effektiven Einsatz von Proxies beim Scraping

- Proxys rotieren: Vermeiden Sie es, mehrere Anfragen von einer einzigen IP-Adresse zu senden.

- Umsetzung von Antragsverzögerungen: Verringern Sie das Entdeckungsrisiko, indem Sie die Anforderungsrate anpassen.

- Verwenden Sie kopflose Browser: Tools wie Puppeteer oder Selenium imitieren menschliches Verhalten.

- Proxy-Leistung überwachen: Überprüfen Sie regelmäßig die Latenz, die Betriebszeit und die IP-Reputation.

- Testen Sie Proxies vor der Bereitstellung: Führen Sie Tests in kleinem Maßstab durch, um die Zuverlässigkeit zu gewährleisten.

Schlussfolgerung

Gute Proxy-Sites verbessern die Effizienz des Scrapings, verringern das Risiko von Sperrungen und gewährleisten einen nahtlosen Zugang zu wertvollen Daten. Anbieter wie OkeyProxy bieten hervorragende, auf das Scraping zugeschnittene Funktionen. Ein Verständnis der Proxy-Typen und der besten Praktiken wird Web-Scraping-Projekte optimieren.

Für weitere Einblicke in proxy-bezogene Themen können Sie gerne zusätzliche Ressourcen nutzen!

-